Was ursprünglich als originelle Science Fiction Idee begann, formiert sich langsam aber unaufhaltsam zu einer neuen These der Astrophysik. Eine These, die endlich mit den ganzen Widersprüchen und ungeklärten Fragen und Problemen aufräumen könnte.

Eine These aber auch, die noch unschmeichelhafter und ernüchternder ist als die Erkenntnis, dass der Mensch vom Affen abstammt (Darwin), dass das Universum zufallsbestimmt ist (Quantenmechanik), oder dass Gott tot ist (Nietzsche).

Schenk uns bitte ein Like auf Facebook! #meinungsfreiheit #pressefreiheit

Danke!

Themenübersicht:

- Historie der Simulationsthesen

- Ungelöst: Was die Welt im innersten zusammenhält.

- Die Sache mit den Quanten und der quantisierten Raumzeit.

- Die Quantenunschärfe - Und Gott würfelt doch!

- Die Diskrepanz zwischen Teilchen und Wellen: Ist das Licht nun Welle oder Photonengeschoss?

- Die Quantenverschränkung. Physikalisch unmöglich, aber Realität.

- Raum, Zeit und Lichtgeschwindigkeit. Erstere sollen relativ sein, damit das Licht konstant sein kann?

- Die Sache mit den vielen Dimensionen

Historie der Simulationsthesen

Um 300 v. Chr. träumte der Philosoph Zhuang Zhou, er wäre ein Schmetterling, der mit sorgloser Leichtigkeit herumflog. Der Traum war so real, dass er, als er erwachte, sich fragte, ob er Zhuang Zhou war, der geträumt hatte, er sei ein Schmetterling, oder ob er ein Schmetterling war, der träumte, er sei Zhuang Zhou. Wenn ein Traum real scheint, wie kann man feststellen, was die Realität ist?

Im 17. Jahrhundert schreibt der Philosoph René Descartes (Ich denke, also bin ich), dass er zwar nicht bezweifeln kann, dass es ihn als Erkenntnissubjekt gibt, dass er seinen Wahrnehmungen aber nicht trauen könne, weil denkbar ist, dass ein böser Geist möglicherweise alle seine Erfahrungen steuert. An anderer Stelle erwähnt er, er könne seinen Wahrnehmungen nicht trauen, weil er sie möglicherweise nur träume.

Um 1945 entwirft der Erfinder und Computerpionier Konrad Zuse die Hypothese, dass das Universum als digitale Maschine verstanden werden kann, aufbauend auf Stanislaw Marcin Ulams Arbeiten zu zellulären Automaten.

1964 erscheint der Science-Fiction-Roman „Simulacron-3“ von Daniel F. Galouye, 1973 durch Rainer Werner Fassbinder als „Welt am Draht“ verfilmt. Es geht um eine zu Marktforschungszwecken kreierte virtuelle Großstadt, deren Bewohner eigenständiges Bewusstsein entwickeln. Zeitgleich kommt dem Romanhelden der sich bestätigende Verdacht, dass er selber in einer Simulation lebt und eine Simulation in der Simulation geschaffen wurde.

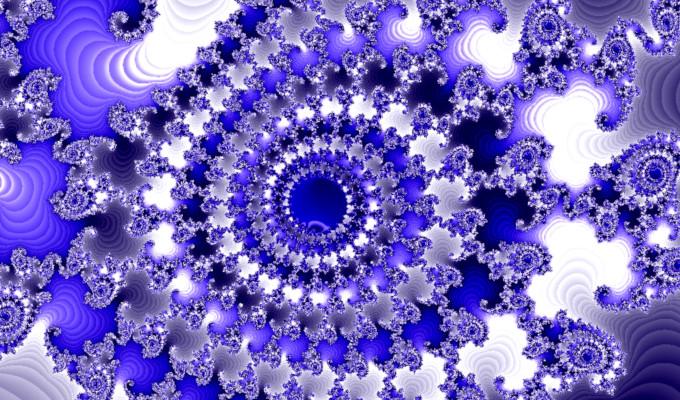

1975 prägt der Chaosforscher Benoît Mandelbrot den Begriff „Fraktal“, um komplexe Vorgänge aus Kosmologie, Natur aber auch Finanzwirtschaft zu beschreiben und grafisch anschaulich darzustellen. Seinerzeit neu und verblüffend war, dass die zufällige Variation von Grundmustern, die auf ebenfalls zufällige Weise zu komplexen Gebilden zusammengesetzt werden, immer wieder zu ähnlichen Strukturen (oder Ereignissen) führt und in der grafischen Darstellung teilweise an Strukturen der Biologie, teilweise an solche des Kosmos erinnert. Möglich wurde diese Erkenntnis überhaubt erst durch Computer, die diese schlichten aber extrem umfangreichen Berechnungen (im Prinzip Simulationen) ausführen konnten.

1982 veröffentlicht der Philosoph Hilary Whitehall Putnam die Idee vom „Gehirn im Tank“, ein Gedankenexperiment, bei dem es darum geht, die Beziehung zwischen Erkenntnissubjekt und Welt zu hinterfragen.

1999 erscheint der Film "Matrix". Seine Handlung basiert teilweise auf "Welt am Draht", teilweise aber auch auf dem "Gehirn im Tank" Gedanken.

Ende des 20. Jahrhunderts legten Astrophysik-Forscher eine Theorie vor, die als Holographisches Universum bekannt ist. Sie vermuten, dass alles, was unsere dreidimensionale Realität ausmacht, von massiven Sternen bis hin zu winzigen Atomen, eigentlich in einer zweidimensionalen Ebene ausgebildet ist, dass also das komplette Universum eigentlich nur auf einer Daten-Matrix basiert. Eine Studie bestätigte inzwischen, dass es deutliche Hinweise darauf gibt, dass das Universum nur eine riesige Illusion ist, ausschließlich aus Informationen bestehend.

2003 veröffentlicht der Philosoph Nick Bostrom seine Simulationshypothese. Dass das Weltall nur eine Simulation ist, ist dabei nur eine von drei Möglichkeiten, wobei ihm aber geradezu zwingend erscheint, dass Zivilisationen, die lange genug überleben, solche Simulationen schaffen werden. Die eigentliche Frage ist also, ob es weitere Zivilisationen gibt und ob die lange genug überlebt haben, überleben können, um den notwendigen technischen Standard erreichen zu können.

Seit 2018 erforschen Wissenschafter der Universität Wien um Harold Steinacker die sogenannte Matrix-Theorie als Alternative zur Stringtheorie. Es geht dabei allerdings nicht um eine Welt am Draht, sondern eher um den Versuch, das Universum als ein auf schlichten Matrizen (Informationen und Gesetzmäßigkeiten) beruhendes 4-dimensionales Fraktal zu beschreiben. Wobei das eine (natürliches Fraktal) das andere (Computersimulation) natürlich nicht ausschließt.

Ungelöst: Was die Welt im innersten zusammenhält.

Je mehr der Mensch über die Welt herausfindet, desto widersprüchlicher und verwirrender wird sie, und der sogenannte Ereignishorizont hängt wie ein eiserner Vorhang vor der eigentlichen Maschinerie des Universums. Was aber, wenn das Universum nur eine Computersimulation wäre? Diese würde ermittel- und nachvollziehbaren Gesetzmäßigkeiten folgen, aber es wäre den in ihr agierenden Probanden unmöglich, Erkenntnisse zu erlangen, wie das Ganze überhaupt funktioniert und was jenseits der Simulation liegt. Das läge hinter ihrem virtuellen Ereignishorizont, so, wie auch große Teile des Universums unseren Blicken verborgen sind, da das Licht nicht schnell genug ist, um uns je von dort zu erreichen.

Ein virtuelles Universum würde den Algorithmen, den vorgegebenen Gesetzmäßigkeiten folgen, es wäre folgerichtig, aber es wäre nicht zwingend notwendig, dass diese Algorithmen eine gemeinsame, logische Basis hätten, konkret: Man könnte Ausnahmen programmieren, und Dinge, die nicht miteinander korrespondieren, könnten problemlos unterschiedlichen, widersprüchlichen Gesetzmäßigkeiten folgen.

Die Sache mit den Quanten und der quantisierten Raumzeit.

Bevor jetzt alle dicht machen und behaupten, das könne eh keine Sau verstehen, gehe ich gleich mal auf den Computer ein. Woher kennen wir Quanten bzw. Quantisierung? Genau, das ist im Prinzip das Gleiche wie Digitalisierung. Analoge Vorgänge werden in einzelne Werte (Quanten, Bytes) zerlegt, um so gespeichert und/oder digital weiter verarbeitet werden zu können. Bilder bestehen aus Pixeln. Filme bestehen aus einzelnen Bildern. Klänge aus einzelnen Samples (Werten), die den analogen Schwingungen entnommen werden. Ist die Anzahl und die Frequenz der so genommenen Werte hoch genug, entsteht für uns der Eindruck der Analogität.

Genau das Gleiche, nur mit trilliardenfach höherer Auflösung, hat man jetzt auch über das Universum, über die sogenannte reale Welt, herausgefunden. Alles besteht nur aus Bruchstücken. Selbst Raum und Zeit sind offenbar gequantet.

Entweder also ahmen unsere Computer die Natur nach, oder aber die Natur ist eigentlich ein Computer.

Die Quantenunschärfe - Und Gott würfelt doch!

Wenn ein Schütze mit einem Gewehr Bleikugeln auf eine Zielscheibe schießt, sind die Treffer gestreut, je nachdem, wie gut der Schütze ist. Stellt man das Gewehr aber auf ein Stativ und schaltet Umwelteinflüsse wie Wind weitgehend aus, dann werden die Treffer immer voll ins Schwarze gehen. Nicht so bei den Elementarteilchen. Schießt man zB. Elektronen in eine bestimmte Richtung, so ist das Ergebnis immer gestreut. Und noch verrückter: Stellt man vor dem Ziel, auf halber Strecke, einen senkrechten Spalt auf, so dass die Treffer eigentlich nur noch in der Senkrechten streuen dürften, so streuen die Elektronen trotzdem auch in die Breite. Ihre Streuung, ihre Ungenauigkeit hat also nichts mit dem Abschuss zu tun, sondern ist offenbar Bestandteil des Teilchens. Das Teilchen ist nie exakt an einem bestimmten Ort, sondern nur mit hoher statistischer Wahrscheinlichkeit in großer Nähe des Ortes, wo man es vermutet, mit abnehmener Wahrscheinlichkeit in geringerer Nähe, und mit geringer Wahrscheinlichkeit fliegt es sogar in die entgegengesetzte Richtung oder materialisiert in Australien.

Solches nur im Rahmen von Wahrscheinlichkeit vorhersehbares, zufälliges Verhalten widerspricht jeder Vorstellung von Raum, Zeit und Materie, ebenso wie von physikalischer und mechanischer Folgerichtigkeit. Im Rahmen einer Simulation, eines Fraktales aber ist der Zufall unverzichtbarer Bestandteil, wie die dennoch geordneten grafischen Darstellungen solcher Fraktale zeigen.

Die Diskrepanz zwischen Teilchen und Wellen: Ist das Licht nun Welle oder Photonengeschoss?

Diese Gleichzeitigkeit von Wellen und Teilcheneigenschaften wurde inzwischen für alle Elementarteilchen nachgewiesen (auch Atome, Elektronen, Neutronen usw.). Es ist sogar noch verrückter: Schießt man ein einzelnes Elementarteilchen durch einen Doppelspalt, so durchquert es aufgrund seiner Quantenunschärfe offenbar beide Spalte und bildet anschließend wellengleiche Interferenzen, die die Wahrscheinlichkeit bestimmen, wo es letztlich einschlägt. Soll heißen, bei den zu erwartenden Interferenzmaxima häufen sich die Einschläge, was in der Masse der Teilchen dann zu den beobachteten Wellenmaxima führt.

Und es wird noch verrückter: Beobachtet man, durch welchen der beiden Spalte das Elementarteilchen nun tatsächlich fliegt, Unschärfe hin oder her, so erlischt das Wellenverhalten und es schlägt ganz normal gestreut wie beim Einzelspalt ein.

Daraus schlossen einige Physiker, vor allem aber Esoteriker und Simulationsthesenbefürworter, dass die Natur (oder Gott, oder das Programm) merken, wenn sie beobachtet werden und sich dann schnell folgerichtig und logisch verhalten. Die viel naheliegendere Erklärung ist aber:

Elementarteilchen verhalten sich unbestimmt (quasi Zufallsgenerator auf Abruf) solange sie nicht mit anderen Teilchen interagieren. Diese Zufallsfunktion ist sehr ökonomisch (sparen von Rechenkapazität) in simplen Wellenfunktionen untergebracht. Sobald aber ein Teilchen mit einem anderen agiert, wird es konkret, und sein weiteres Verhalten wird konkret und muss (so es sich um eine Simulation handelt) im konkreten Einzelfall berechnet werden.

Auch die Beobachtung im Bereich der Elementarteilchen ist eine solche Interaktion, denn natürlich kann man nicht „gucken“, was das Elementarteilchen so treibt, man kann es nur mit anderen Elementarteilchen beschießen, um etwas über sein Verhalten in Erfahrung zu bringen. Und genau und erst dann werden Elementarteilchen von der simplen Zufall simulierenden Wellenfunktion zum konkreten Objekt. Rechenkapazität wird gespart und konkrete Einzelfallberechnungen erfolgen nur bei Interaktion der Teilchen. So kann man den Rechenaufwand für das Universum auf einen Trilliardstel Bruchteil reduzieren, obwohl natürlich immer noch genug übrig bleibt, um gegenwärtige und auch zukünftige Rechnergenerationen grandios mit ihren Grenzen zu konfrontieren.

Die Quantenverschränkung. Physikalisch unmöglich, aber Realität.

Vereinfacht ausgedrückt: Wenn man Elementarteilchen dazu anregt, ein Teilchenpaar abzusondern (zB. Elektronen), so sind diese Teilchen in ihrem Verhalten gekoppelt, der Physiker spricht von „verschränkt“. Interessant wird das erst, wenn man dieses Quantenpaar räumlich trennt, viele Kilometer zwischen die beiden bringt. Wenn jetzt das eine Teilchen durch „Beobachtung“ (Interaktion) dazu angeregt wird, einen konkreten Zustand anzunehmen, so nimmt das andere Teilchen, offenbar völlig zeitgleich, den entsprechenden „Partnerzustand“ an. Nach Einstein können diese Teilchen maximal mit Lichtgeschwindigkeit miteinander kommunizieren, das zweite Teilchen müsste also mit messbarer Verzögerung reagieren. Tut es aber nicht. Die Messungen ergaben, dass ein Informationsaustausch (eine Reaktion) mindestens tausendmal schneller als das Licht erfolgt, vermutlich also sofort, in Nullzeit.

Das widerspricht allen physikalischen Gesetzmäßigkeiten, selbst denen der skurrilen Quantenmechanik. Gleichzeitig wurde kaum etwas in der Physik vergleichbar oft experimentell erforscht und bestätigt. Die Quantenverschränkung ist Realität.

In einer Computersimulation wäre das aber überhaupt kein Problem.

Die verschränkten (gekoppelten) Teilchen würden sich als Information in benachbarten Speichern befinden und ihre Position würde nur Veränderungen in ihrem ebenfalls gespeicherten Koordinatensystem bewirken, tatsächlich liegen sie aber nach wie vor, als "Kumpels" direkt nebeneinander und können „schauen“, was der andere so tut.

Raum, Zeit und Lichtgeschwindigkeit. Erstere sollen relativ sein, damit das Licht konstant sein kann?

Das ist harter Tobak für den gesunden Menschenverstand. Der Raum dehnt sich permanent in die Zeit aus, und die Zeit ist abhängig davon, wie schwer ein Körper ist oder wie schnell er sich bewegt. Dadurch ist dann auch die zulässige Höchstgeschwindigkeit limitiert, weil die Zeit immer langsamer und die Masse/Trägheit immer größer wird, je schneller sich ein Objekt bewegt. Das alles widerspricht unserer alltäglichen Vorstellung von Realität.

Was aber, wenn die Lichtgeschwindigkeit, die zulässige Höchstgeschwindigkeit, die schnellst mögliche Wechselwirkung, schlicht und einfach die Rechengeschwindigkeit des Computers wäre? Die Zeit an sich schlicht auf seiner Rechengeschwindigkeit basiert ? Ein Objekt, dass sich mit Lichtgeschwindigkeit bewegt, bringt dann den Computer an seine Grenzen. Auf diesem Objekt kann nichts mehr passieren (die Zeit steht still, da keine Rechenkapazität mehr vorhanden). Und schneller geht halt auch nicht, weil dem Rechner längst die Puste ausgegangen ist.

Diese Idee funktioniert auch für schwarze Löcher. Wenn die Ansammlung von Masse = Partikeln so hoch wird, dass sie an die Grenzen der lokalen Rechenkapazität stößt, gibt es einen Kollaps der Zeit. Im inneren des schwarzen Lochs steht sie still, keine Wechselwirkung kann mehr stattfinden und damit auch nichts mehr das schwarze Loch verlassen.

Und das funktioniert auch für den Horizont des Universums. Je weiter entfernt Galaxien von uns sind, desto länger braucht das Licht (die interne Datenübermittlung), um zu uns zu gelangen. Es gibt einen Horizont, wo das Alter des Universums nicht ausreicht, damit das Licht zu uns hätte gelangen können. Was dahinter ist, weiß man nicht. Was, wenn auch da der Rechner schlicht an die Grenzen seiner Rechenkapazität stößt, also die Dinge hinterm Horizont gar nicht erst berechnen kann, weil seine Verarbeitungsgeschwindigkeit dafür nicht mehr ausreicht. Ein kluges Programm würde sich vorher ausklinken und leere Informationen zurückliefern, so, wie es auch vermeidet, in Endlosschleifen zu geraten.

Die Sache mit den vielen Dimensionen

Einsteins Weltbild mit den 4 Dimensionen, das war noch eine "runde" Sache. Das 3-dimensionale Universum, in die 4. Dimension (die Zeit) gekrümmt. Die Sache mit dem Ballon. Das war nachvollzieh- und vorstellbar. Inzwischen geht die Wissenschaft von mindestens 11, in Einzelfällen gar unendlich vielen Dimensionen aus. Hat uns das irgendwie weiter gebracht? Nein. Es sorgt nur dafür, dass auf Thesen und Vermutungen basierende mathematische Berechnungen aufgehen, oder einzelne, teilweise widersprüchliche Phänomene erklärt werden können, andere dafür wiederum nicht.

Nur keinen Respekt vor Wissenschaftlern. Die Wissenschaft ist eine Geschichte endloser Irrtümer und abenteuerlicher Fehleinschätzungen. Das Einzige, was Wissenschaft von Religion unterscheidet, ist, dass sie ständig alte Irrtümer durch neue ersetzt. Ein Erfolgskonzept gegenüber Religionen und Ideologien, die stur auf alten, längst widerlegten Irrtümern beharren.

Was wäre jetzt, wenn wir uns in einer Matrix befänden?

Kleines Gedankenexperiment: Die erste notwendige Dimension wäre die Zeit. Kein Prozessortakt, keine zeitliche Abfolge von Rechenschritten, kein Ergebnis. Und diese Zeit muss mehrdimensional sein, sonst gäbe es nur ein Ereignis zur Zeit, was auf Dauer ziemlich öde wäre.

Bei derzeitigen Personal Computern gibt es in der Regel 256 Zeitstränge (Parallel ablaufende Rechenprozesse, 4 Kerne a 64 Bit). Das könnte man als rudimentäre 2-dimensionale Zeit bezeichnen, den tatsächlich laufen die Rechenprozesse ja nicht parallel, sondern können sich überkreuzen (miteinander agieren) und neue Verläufe in der zweidimensionalen Zeitebene hervorrufen.

Auf jedem einzelnen Rechen- bzw. Zeitstrang baut jetzt ein dreidimensionales Koordinatensystem auf, das festlegen kann, wo sich etwas befindet und wie groß es ist. Auf den 2 Zeitdimensionen bauen also je 3 Raumdimensionen auf. Und schon haben wir 6 Dimensionen, plus 2 Zeitdimensionen. Oder, wenn man die Zeit als dreidimensional annimmt (zB. für weitere Universen), eben 9 + 3 Dimensionen. Na geht doch. Es hat nach wie vor alles seine Ordnung, macht Sinn, und wir geben den Mathematikern und Rechenfuzzies unter den Physikern ihre vielen Dimensionen.

Das alles ist natürlich pure Spekulation. Aber ganz ehrlich, die meisten astrophysikalischen Thesen auch. Auch und gerade, wenn sie sich hinter Komplexität und Mathematik verstecken wie zB. die Stringtheorie, die in über 30 Jahren computergestützter Denk- und Rechnerei eigentlich nichts Vernünftiges hervorgebracht hat, sondern immer nur neue Thesen, Fragen und Widersprüche.